Nvidia는 AI를 위한 ‘슈퍼칩’ Grace-Hopper를 더 빠른 메모리로 강화합니다.

Nvidia enhances 'superchip' Grace-Hopper for AI with faster memory.

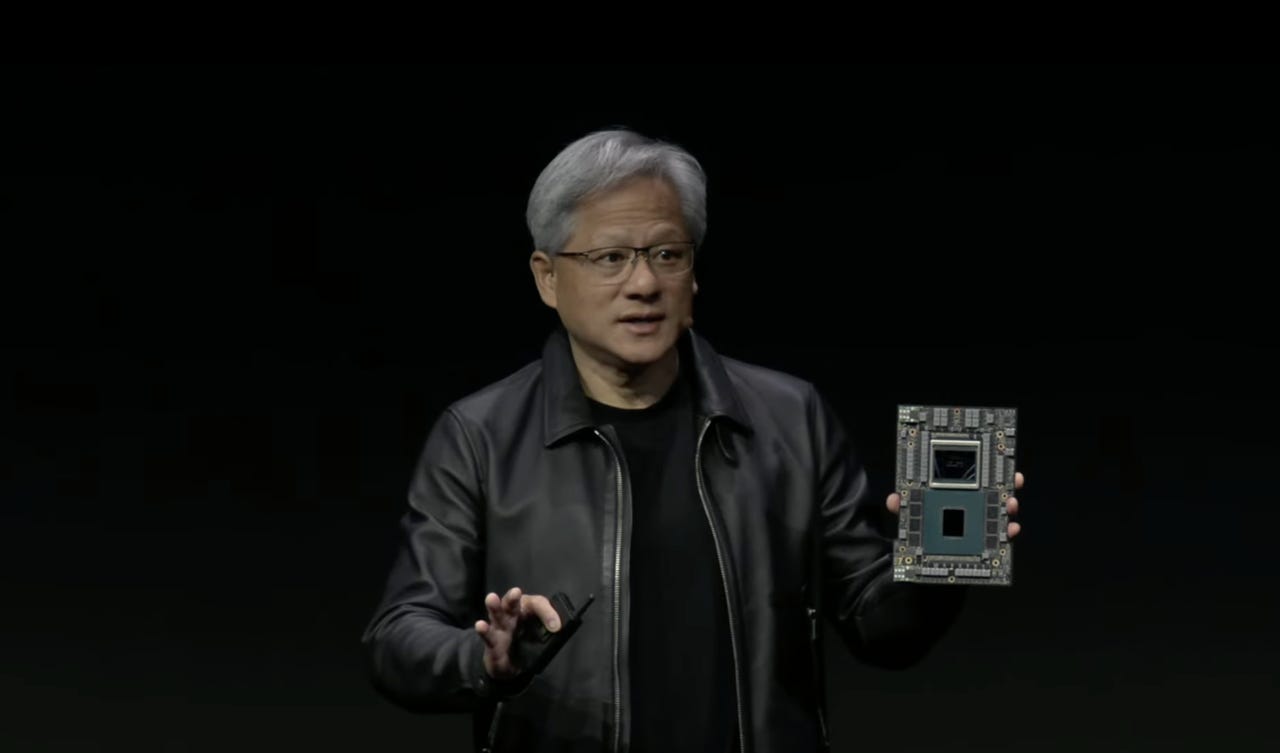

Nvidia CEO Jensen Huang는 화요일에 그의 회사의 다음 세대 CPU와 GPU 조합인 “GH200” Grace Hopper “슈퍼칩”을 선보였습니다. 이 부품은 인공지능 모델의 크기 증가에 대응하기 위해 메모리 용량을 초당 5 테라바이트로 늘렸습니다.

Nvidia는 내년에 CPU와 GPU를 결합한 “슈퍼칩”의 향상된 버전을 출시할 계획입니다. 이 슈퍼칩은 더 빠른 메모리를 사용하여 칩의 회로로 더 많은 데이터를 이동시킬 수 있습니다. Nvidia CEO Jensen Huang은 화요일에 SIGGRAPH 컴퓨터 그래픽 쇼에서 키노트 연설 중 발표했습니다.

GH200 칩은 이미 올해 초에 발표된 Grace Hopper 콤보 칩의 다음 버전으로, 이미 Dell 등의 컴퓨터에서 초기 버전으로 사용되고 있습니다.

또한: Nvidia가 AI를 위한 새로운 이더넷과 Grace Hopper ‘슈퍼칩’을 전격 공개

초기 Grace Hopper는 Hopper GPU에 데이터를 공급하기 위해 96 기가바이트의 HBM 메모리를 사용하였으나, 새로운 버전은 HBM3e인 140 기가바이트의 HBM3e를 사용합니다. HBM3e는 원래 Grace Hopper의 4 테라바이트에서 초당 5 테라바이트로 GPU에 데이터를 공급하는 데이터 전송 속도를 향상시킵니다.

GH200는 1년 뒤에 원래의 Grace Hopper를 따라 나오게 되며, 이전에 5월에 Huang이 전체 생산 중이라고 말한 바 있습니다.

“칩은 생산 중이며, 연말이나 그 이후에 샘플을 제공하고, 2024년 두 번째 분기까지 생산될 것입니다,” 그는 화요일에 말했습니다.

원래 Grace Hopper와 마찬가지로 GH200에는 Grace 칩 내의 72개의 ARM 기반 CPU 코어와 Hopper GPU 내의 144개의 GPU 코어가 포함되어 있습니다. 두 개의 칩은 고속 캐시 일관성 메모리 인터페이스인 NVLink를 통해 회로 기판을 통해 연결되어 있으며, Hopper GPU가 CPU의 DRAM 메모리에 액세스할 수 있도록 합니다.

Huang은 GH200를 두 개의 GH200과 연결하여 듀얼 구성 서버에 연결할 수 있으며, 이렇게 하면 총 10 테라바이트의 HBM3e 메모리 대역폭을 제공할 수 있다고 설명했습니다.

GH200는 CPU와 GPU의 밀접한 결합을 통해 AI 프로그램의 작업을 공유하기 위해 설계된 Grace Hopper 슈퍼칩의 다음 버전입니다.

GPU 부품의 메모리 속도 업그레이드는 Nvidia에게는 상당히 표준적인 일입니다. 예를 들어, 이전 세대 GPU인 A100 “Ampere”는 HBM2에서 HBM2e로 이동했습니다.

HBM은 비디오 게임 그래픽을 위한 4K 디스플레이의 증가하는 메모리 요구에 따라 2015년에 이전 GPU 메모리 표준인 GDDR을 대체하기 시작했습니다. HBM은 개별 메모리 다이를 서로 쌓아 올린 “스택” 형태의 메모리 구성으로, 각 칩 사이를 연결하는 “스루 실리콘 비아”를 통해 각 칩 사이의 표면에 “마이크로 범프”로 연결됩니다.

특히 ChatGPT와 같은 생성적 AI 유형의 AI 프로그램은 매우 메모리 집약적입니다. 그들은 신경망의 주요 기능 단위인 가중치 또는 매개변수의 엄청난 수를 저장해야 합니다. 이러한 가중치는 대형 언어 모델과 같은 생성적 AI 프로그램의 각 새로운 버전마다 증가하며, 1조 개의 매개변수로 향하고 있습니다.

또한: Nvidia가 AI 벤치마크에서 우위를 점하고 있지만, Intel은 의미 있는 경쟁을 제공합니다.

쇼 중에 Nvidia는 몇 가지 다른 제품과 파트너십을 발표했습니다.

AI Workbench는 로컬 워크스테이션에서 실행되는 프로그램으로, 컨테이너화된 방식으로 클라우드에 신경망 모델을 업로드하기 쉽게합니다. AI Workbench는 현재 초기 접근을 위한 사용자를 모집하고 있습니다.

“RTX” 브랜드 아래에서 Dell, HP, Lenovo 등으로부터 생성적 AI를 위한 새로운 워크스테이션 구성이 발표될 예정이며, 각각 48 기가바이트의 메모리를 가진 “RTX 6000 Ada GPU”를 최대 4개까지 결합할 수 있습니다. 각 데스크탑 워크스테이션은 초당 5,828 조 개의 부동 소수점 연산(테라플롭)의 AI 성능과 192 기가바이트의 GPU 메모리를 제공할 수 있다고 Nvidia는 밝혔습니다.

Huang의 전체 기조연설의 재생을 Nvidia 웹사이트에서 시청하실 수 있습니다.