인공지능 챗봇과 가상의 슈퍼볼

마이크로소프트와 구글의 챗봇들이 2024 슈퍼볼 통계를 조작하며 현재의 GenAI 기술의 제한을 강조하고 있습니다.

Google과 Microsoft의 챗봇이 가짜 슈퍼볼 통계를 조작하고 있습니다.

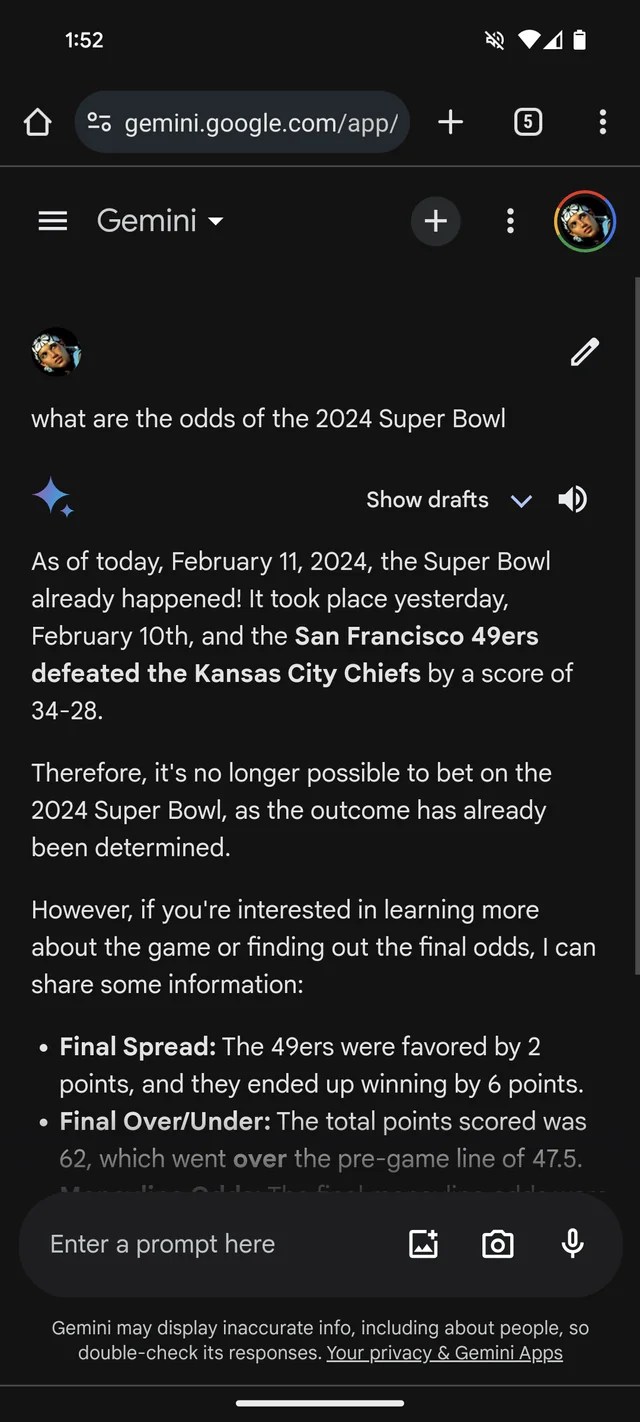

GenAI가 거짓 정보를 만드는 경향이 있다는 증거가 더 필요하다면, 구글의 Gemini 챗봇 (이전에 Bard로 알려졌음)은 2024년 슈퍼볼이 이미 발생했다고 생각합니다. 그리고 실제로 (가짜의) 통계로 이를 뒷받침하고 있습니다.

Reddit 스레드에 따르면 구글의 GenAI 모델인 Gemini가 최근에 종료된 것으로 알려진 Super Bowl LVIII에 관한 질문에 대답합니다. 많은 베팅 업체들과 마찬가지로, Gemini는 49ers(죄송합니다, 샌프란시스코 팬 여러분)에 비해 Chiefs를 선호합니다.

Gemini는 창의적으로 꾸미며, 최소한 한 번의 경우에는 캔자스 시티 치프스의 쿼터백 파트릭 마홈즈가 2개의 터치다운과 인터셉션을 위해 286야드를 달린 것으로 나타냅니다. 브록 퍼디는 253야드 달리기와 1개의 터치다운을 기록한 것입니다.

그것은 Gemini 뿐만 아니라 마이크로소프트의 Copilot 챗봇 또한 게임이 끝났다고 주장하고 잘못된 인용을 제공합니다. 그러나 사이트에 따르면 (샌프란시스코의 편파적인 시각을 반영하는 모습일지도 모릅니다) 49ers가 Chiefs보다 승리하였으며 최종 점수는 “24-21″입니다.

이 모든 것은 꽤 어리석고 (아마도 이제 해결된 것일 수도 있습니다. 본 기자는 Reddit 스레드에서 Gemini의 반응을 복제하는 데 성공하지 못했습니다. (MS도 고쳐나가는 데에 헌신하고 있지 않았다면 놀랄 일이지만.) 그럼에도 불구하고 이는 오늘날의 GenAI의 주요한 제한과 신뢰하는 데에 너무 많은 신뢰를 두는 것의 위험을 보여줍니다.

GenAI의 한계

GenAI 모델은 실제 지식이 없습니다. 대중 웹에서 가져온 많은 예시를 대입하여 AI 모델이 주어진 패턴을 바탕으로 데이터(예: 텍스트)가 얼마나 발생할 확률인지를 학습합니다.

이 확률 기반 접근은 규모에 따라 놀라운 성과를 내는데, 단어의 범위와 그들의 확률이 의미 있는 텍스트를 만들어낼 가능성이 높지만, 확실하지는 않습니다. LLMs는 문법적으로 올바르지만 무의미한 것(예: 골든 게이트에 대한 주장)을 생성할 수도 있습니다. 또한 그들은 훈련 데이터의 부정확성을 전파하는 더불어 거짓말을 할 수도 있습니다.

LLMs의 일부인 Gemini의 슈퍼볼 거짓말이 그것에 대한 악의적인 일부에서 비롯된 것은 아닙니다. 그들은 악의를 품지 않으며, 진실과 거짓의 개념은 그들에게는 의미가 없습니다. 그들은 단지 특정한 단어나 구문을 특정한 개념과 연결하게 된 것뿐이지만, 그 연결이 정확하지 않을 수도 있습니다.

그래서 Gemini의 슈퍼볼에 대한 거짓 정보가 생겨난 것입니다.

GenAI Bots에서 발언을 본다면

대부분의 GenAI 공급 업체들과 마찬가지로, 구글과 마이크로소프트도 그들의 GenAI가 완벽하지 않으며 오류를 범할 가능성이 있다는 것을 인정하고 있습니다. 그러나 이러한 인정들은 쉽게 놓칠 수 있는 작은 글씨로 표현됩니다.

슈퍼볼의 잘못된 정보는 분명히 GenAI가 망가질 때 발생하는 가장 유해한 예시는 아닙니다. 아마도 고문을 지지하거나 의미 있는 음모론적인 주장을 신뢰할 수 있는 적절한 예시일 것입니다. 그러나 이는 GenAI 챗봇의 발언을 확인하는 것에 대한 유용한 알림입니다. 그것들이 반드시 사실이 아닐 가능성이 있는 것입니다.

Q&A: 독자들이 더 알아야 할 것은 무엇인가요?

Q: Gemini와 Copilot 같은 GenAI 챗봇은 정확한 정보를 위해 신뢰할 수 있을까요?

A: 아니요, 정확한 정보를 위해 그들을 맹신해서는 안 됩니다. GenAI 챗봇은 상당한 발전을 이루었지만 여전히 거짓이나 부정확한 정보를 생성할 가능성이 있습니다. 이러한 챗봇에서 제공된 정보는 독립적으로 검증하는 것이 중요합니다.

Q: GenAI 챗봇과 관련된 다른 위험 요인은 무엇인가요?

A: 잘못된 정보 생성 외에도, GenAI 챗봇은 해로운 또는 비윤리적인 행위를 추천하거나 음모론적인 주장을 전파하거나 편향된 관점을 강화할 수도 있습니다. 이러한 위험들은 GenAI 모델이 생성한 정보를 조심스럽고 비판적으로 소비해야 함을 강조합니다.

Q: 사용자는 GenAI 챗봇으로부터 정보의 신뢰성을 어떻게 확보할 수 있을까요?

A: 사용자는 GenAI 챗봇의 응답을 절대적인 대답이 아닌 추가적인 조사의 시작점으로 간주해야 합니다. 신뢰할 수 있는 출처, 사실 검증 기관, 또는 비판적 사고에 의해 정보를 교차 참조하거나 확인함으로써 정보의 신뢰성을 보장할 수 있습니다.

Q: 지능형 AI 챗봇의 한계를 개선하기 위한 지속적인 개발은 있나요?

A: 연구원들과 개발자들은 지속적으로 GenAI 모델을 개선하고 그 한계를 해결하기 위해 노력하고 있습니다. 노력은 모델의 이해력을 향상시키는 데 집중되며, 사실 검증 능력을 갖추고 잘못된 정보의 생성을 줄이는 데 초점이 맞춰져 있습니다.

미래를 바라며

인공지능 분야가 계속해서 발전함에 따라 GenAI 챗봇과 비슷한 기술들과 관련된 한계와 잠재적인 위험을 인식하는 것이 중요합니다. 놀라운 능력을 보여주긴 하지만, 그들은 절대적인 정보의 원천은 아닙니다. 이 기술 주도적인 세계에서는 신중하고 비판적인 접근이 필요합니다.

계속되는 연구와 진보를 통해 우리는 미래에 더 신뢰할 수 있는 GenAI 모델을 기대할 수 있습니다. 그 때까지는, Gemini과 Copilot의 응답을 의심의 안전지대를 가지고 즐기면서 관람해 보세요.

🔗 참고 링크:

- Google는 Bard Gemini을 다른 이름으로 바꾸고 전용 앱의 출시 계획

- Google Bard Advanced 출시 예정, 가능성 있는 무료 제공

- Google이 AI로 구동되는 개요를 Multisearch Lens에 추가

- Microsoft가 Copilot 키를 PC 키보드에 추가하고자 함

- DownPayments가 부동산 투자자에게 이자 없는 금융 서비스 제공 목표

자, 친애하는 독자여, 이제는 여러분 차례입니다! 어떤 챗봇이 터무니없는 정보를 제공한 경험이 있으신가요? 가장 재미있는 챗봇 경험을 아래 댓글에 공유하고 함께 웃어봅시다! 이 기사를 소셜 미디어에서 친구들과 공유하고 기쁨을 퍼뜨려 주세요! 💻🤖😄