메타가 ‘시흐리스(Seamless)’ 음성 대 음성 번역기를 공개합니다.

Meta unveils 'Seamless' voice-to-voice translator.

페이스북, 인스타그램 및 왓츠앱의 소유자인 Meta는 화요일에 언어 번역을 위한 최신 노력인 음성 번역에 초점을 맞춘 프로그램인 SeamlessM4T를 공개했습니다.

SeamlessM4T 프로그램은 언어 간 음성 번역에 특화된 기존 모델뿐만 아니라 여러 언어 쌍에서 음성과 텍스트 간 변환을 수행하는 모델보다 우수합니다. 따라서 SeamlessM4T는 일반성 뿐만 아니라 multi-modality라고 불리는 한 프로그램이 여러 데이터 유형, 이 경우 음성 및 텍스트 데이터에 작동할 수 있는 능력의 예입니다.

또한: Meta는 OpenAI와 Google과 경쟁하기 위해 오픈 소스 상업용 AI 모델을 출시할 예정입니다

이전에 Meta는 200개 이상의 다른 언어 간에 텍스트를 번역할 수 있는 대형 언어 모델에 초점을 맞추었습니다. 그러나 Meta 및 UC 캘리포니아 버클리 캠퍼스의 주 저자인 Loïc Barrault와 동료들은 텍스트에 초점을 맞추는 것은 문제라고 말합니다.

“NLLB(No Language Left Behind)와 같은 단일한 단일 모달 모델은 텍스트에서 텍스트로 번역(T2TT) 범위를 200개 이상의 언어로 확장하지만, 통합 S2ST [음성-음성-텍스트] 모델은 비슷한 범위나 성능을 달성하기 어렵습니다,” Barrault와 팀은 밝혔습니다.

- 이것들은 당신이 필요로 할 마지막 조명 스탠드입니다.

- 유튜브의 새로운 기능은 당신의 험한 소리로 노래를 식별할 것입니다.

- 메타, 2023년 말까지 메신저에 엔드 투 엔드 암호화 도입 예정

이 형식적인 논문인 “SeamlessM4T — Massively Multilingual & Multimodal Machine Translation”은 Meta의 Seamless Communication 프로젝트를 위한 전용 사이트에 게시되어 있으며, 동반자로 GitHub 사이트도 있습니다.

저자들은 작성한 바와 같이, 공개 도메인에서 이용 가능한 음성 데이터가 훨씬 적기 때문에 음성은 부분적으로 뒷전에 남겨져 왔다고 설명합니다. 그러나 더 깊은 의미가 있습니다. 음성 데이터는 신경망에게 신호로서 기본적으로 더욱 풍부합니다.

“기계 번역 관점에서 음성을 다루는 것이 더 어렵다고 할 때의 도전은 더 많은 정보와 표현적인 구성 요소를 인코딩하기 때문이기도 하며, 이것은 의도를 전달하고 대화 상대 간에 더 강한 사회적 유대감을 형성하는 데서 우수하다는 이유입니다,” 그들은 쓰고 있습니다.

SeamlessM4T의 목표는 음성 데이터와 텍스트 데이터를 동시에 훈련시킨 하나의 프로그램을 만드는 것입니다. “M4T”는 “Massively Multilingual & Multimodal Machine Translation”을 의미합니다. Multi-modality는 이 프로그램의 명시적인 부분입니다.

또한: Meta의 최신 AI 모델은 수백 개의 언어로 콘텐츠를 제공할 것입니다

이러한 프로그램은 때로는 “end-to-end” 프로그램이라고도 불립니다. 왜냐하면 텍스트와 음성에 관련된 부분을 “계단식 모델”과 같이 분리하지 않고 하나의 함수로 구성합니다. 계단식 모델은 프로그램이 먼저 음성을 텍스트로 변환하는 것과 같이 한 가지를 훈련한 다음 음성을 음성으로 변환하는 것과 같이 다른 부분을 훈련합니다.

저자들은 “현재 대부분의 S2ST [음성-음성 번역] 시스템은 번역을 진행하는 여러 하위 시스템으로 구성된 계단식 시스템에 크게 의존합니다. 예를 들어, 자동 음성 인식(ASR)에서 T2TT [텍스트-텍스트 번역]로, 그리고 이후 3단계 시스템에서는 텍스트에서 음성 합성(TTS)까지 진행합니다,”라고 설명합니다.

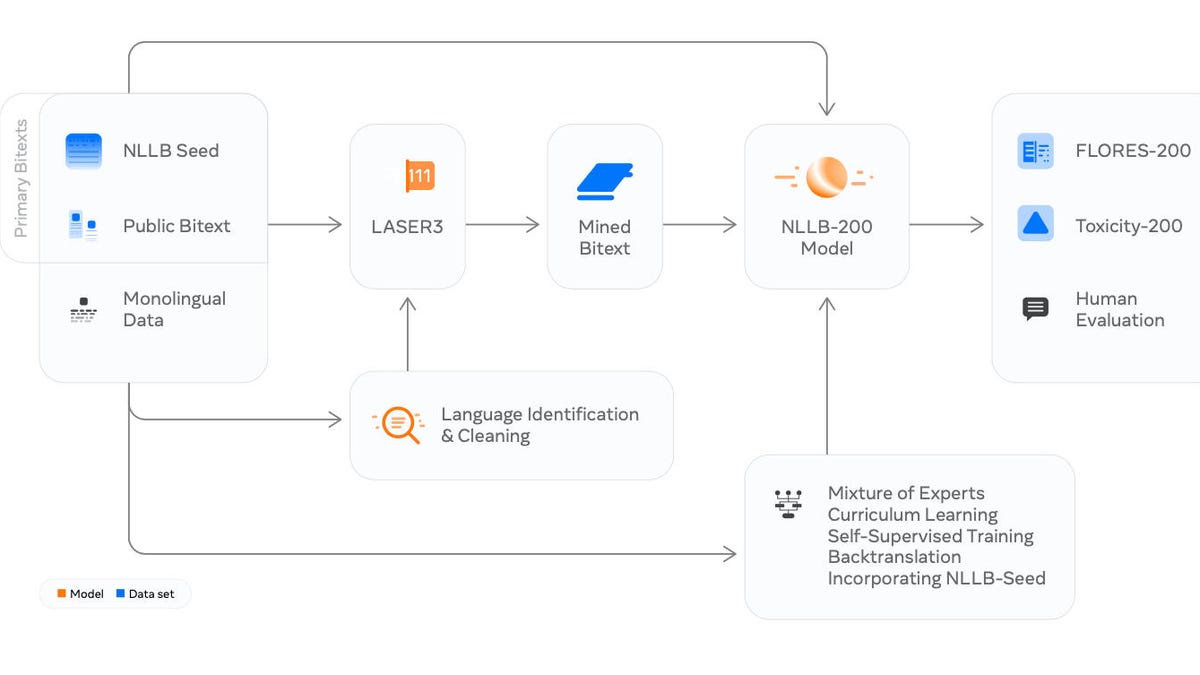

그 대신, 저자들은 여러 기존 부분을 함께 훈련시킨 프로그램을 구축했습니다. 그들은 “SeamlessM4T-NLLB라는 대규모 다국어 T2TT 모델”을 포함시켰으며, “라벨이 없는 음성 오디오 데이터를 활용하는 음성 표현 학습 모델인 w2v-BERT 2.0”, “텍스트에서 단위 시퀀스로 번역하는 텍스트-단위 시퀀스 모델인 T2U”, 그리고 다국어 HiFi-GAN, “단위 보코더로 단위에서 음성을 합성하는 것”을 포함했습니다.

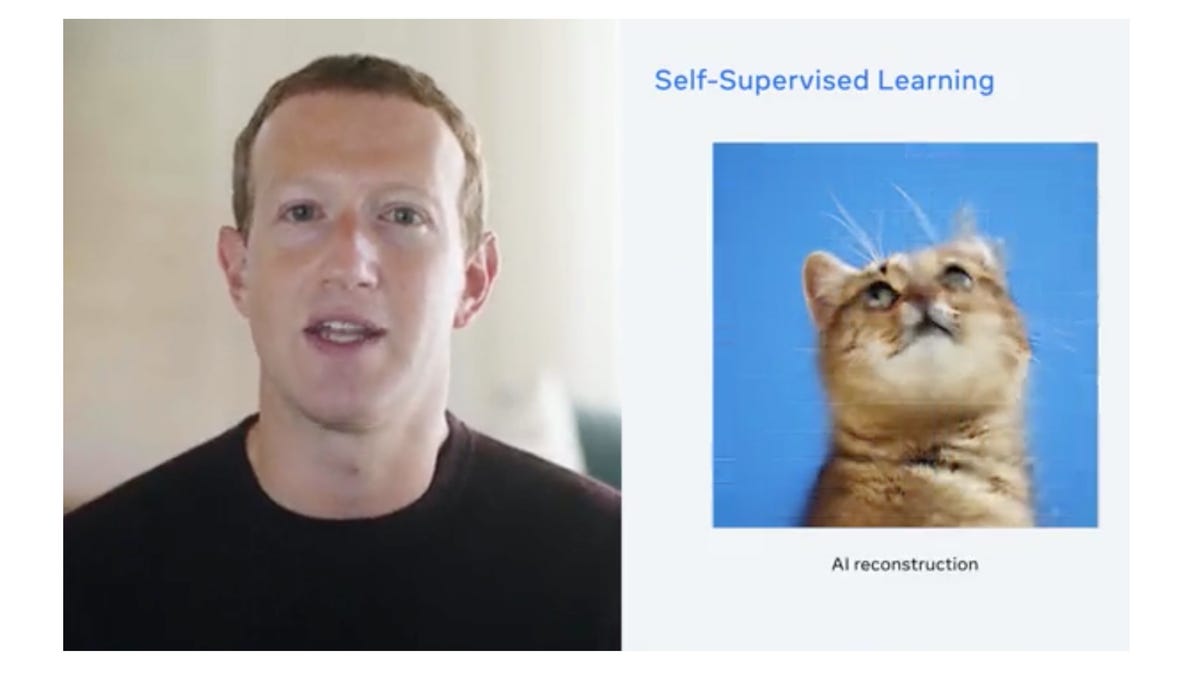

또한: Meta의 ‘data2vec’은 하나의 신경망으로 모든 것을 통치하기 위한 한 걸음입니다

네 개의 구성 요소는 하나의 프로그램에 레고 세트처럼 연결되어 있으며, Meta에서 올해 소개한 UnitY라는 프로그램에 포함되어 있습니다. UnitY는 “텍스트를 생성하고 이후 이산 음향 단위를 예측하는 두 단계 모델링 프레임워크”로 설명할 수 있습니다.

전체 조직은 아래의 다이어그램에서 확인할 수 있습니다.

저자들은 여러 기존 부분을 함께 훈련시킨 프로그램을 구축했으며, 모두 하나의 프로그램에 레고 세트처럼 연결되어 있습니다.

저자들은 보고서에서 이 프로그램이 음성 인식, 음성 번역 및 음성-텍스트 변환의 테스트에서 다른 여러 종류의 프로그램보다 우수한 성능을 보인다고 밝혔습니다. 이에는 엔드 투 엔드인 타인트 프로그램과 음성에 특화된 프로그램들도 포함됩니다:

저희는 두 모델 중 큰 모델인 SeamlessM4T-Large가 이전 최첨단 (SOTA) 엔드 투 엔드 S2TT 모델 (AudioPaLM-2-8B- AST [Rubenstein et al., 2023])보다 Fleurs [Conneau et al., 2022]에서 영어로 번역할 때 4.2 BLEU 점을 더 높은 성능을 보인다는 것을 알게 되었습니다 (즉, 20%의 개선). 단계별 모델과 비교했을 때, SeamlessM4T-Large는 번역 정확도를 2 BLEU 점 이상 향상시킵니다. 영어로 번역할 때, SeamlessM4T-Large는 이전 SOTA (XLS- R-2B-S2T [Babu et al., 2022])보다 CoVoST 2 [Wang et al., 2021c]에서 2.8 BLEU 점을 더 높은 성능을 보이며, 성능은 Fleurs에서 단계별 시스템과 비슷합니다. S2ST 작업에서 SeamlessM4T-Large는 강력한 3단계 단계별 모델 (ASR, T2TT 및 TTS)보다 Fleurs에서 2.6 ASR-BLEU 점을 더 높은 성능을 보입니다. CVSS에서 SeamlessM4T-Large는 큰 폭으로 2단계 단계별 모델 (Whisper-Large-v2 + YourTTS [Casanova et al., 2022])보다 8.5 ASR-BLEU 점을 더 높은 성능을 보입니다 (50%의 개선). S2TT 출력물에 대한 예비적인 인간 평가는 유사한 인상적인 결과를 나타냈습니다. 영어에서의 번역에 대해 24개 언어의 XSTS 점수는 일관되게 5점 중 4점 이상입니다. 영어로 번역할 때, 24개 언어 중 7개 언어에서 Whisper-Large-v2의 기준에 비해 상당한 개선을 볼 수 있습니다.

그리고: Google의 ‘번역 안경’은 실제로 I/O 2023에서 우리 눈앞에 있었습니다

동반 GitHub 사이트는 단순히 프로그램 코드뿐만 아니라 “embedding” 다중 모달 데이터를 위한 새로운 기술인 SONAR와 자동으로 다중 모달 작업을 평가하기 위한 측정 기준인 BLASAR 2.0도 제공합니다.